Si alguna vez mentiste en una entrevista de trabajo con el objetivo de tratar de ganar el empleo, o quizás te sentiste rechazado porque el reclutador pareciera no tener interés en tu persona, ahora un nuevo sistema de inteligencia artificial conocido como Herman PRO busca eliminar parte de esos vicios o retos en el proceso de reclutamiento de personal.

“La pandemia elevó los índices de desempleo de una forma importante. Si queremos apoyar a la reactivación económica los departamentos de recursos humanos deben comenzar a contratar personal, pero bajo los mecanismos actuales de reclutamiento no lo van a lograr o el candidato puede no ser el ideal”, dice en entrevista con Forbes México Cory Rieken, directora de Expansión de Herman PRO, y agrega: “Estamos por entrar en un mundo postpandemia, ninguno de los que vivimos actualmente sabemos cómo es eso”.

Herman PRO fue creado por expertos del mundo de los recursos humanos que buscaban una tecnología para acelerar el proceso de reclutamiento en las empresas, “una de las tareas más complejas, pero también más importantes”, y que, al no encontrar una, decidieron aliarse con ingenieros expertos de firmas como IBM para crear una solución.

Más que ser una plataforma digital de reclutamiento, Herman PRO, dice Germán García, director para México de la firma, utiliza algoritmos de aprendizaje de máquina e inteligencia artificial de millones de entrevistas para tratar de detectar las softskills y aptitudes de un trabajador de forma automática.

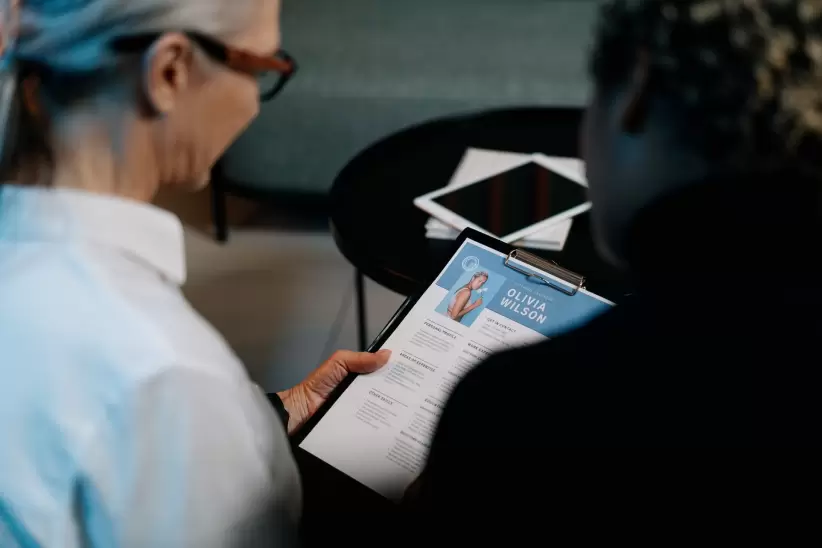

En ese sentido, la inteligencia artificial no le pregunta al candidato temas específicos de una vacante o posición, sino que busca inferir las habilidades blandas del candidato como liderazgo, trabajo en equipo, tolerancia a la frustración, comunicación o similares a través de una “entrevista digital” en la que pueda encontrar patrones o palabras de comportamiento específicos para crear una calificación.

“El sistema te puede decir 'dame un ejemplo de cuando hiciste algo en tu empleo para hacer crecer el negocio'. Herman PRO no califica de bien o mal la respuesta, no da juicios, sino que busca patrones en tu respuesta. Por ejemplo, hemos detectado que las personas que tienden a mentir tienden a hablar en presente, mientras que una persona que realmente está dando un ejemplo habla en pasado porque está recordando el evento”, dice García.

El sistema de inteligencia artificial, dice el experto, hace un análisis del comportamiento frente a cámara de la persona, así como el uso de adjetivos excesivos, verbos o el acomodo de palabras. El sistema funciona a través de una aplicación móvil que el usuario descarga en su teléfono móvil y, una vez asignada la entrevista, entra a la sesión con la diferencia que del otro lado no hay ningún ser humano, sólo una máquina que registra con la cámara y micrófonos del móvil la conversación y un algoritmo, que posteriormente califica al usuario.

La idea, dice Rieken, no es desplazar o sustituir a los departamentos de recursos humanos, sino agilizar el proceso de selección para permitir que el personal se enfoque en los talentos seleccionados, reclute perfiles de mayor nivel o cuente con una cartera de candidatos más extensos.

El objetivo, refiere García, es que los departamentos de RH se dediquen a enfocar su tiempo en perfilar mejor a los candidatos y a tener mejores prospectos, porque “Herman PRO puede entrevistar a diez o veinte personas al mismo tiempo, ellos no”.

¿Sin prejuicios?

De acuerdo a un análisis del World Economic Forum, se ha demostrado que en el mercado laboral de Estados Unidos, “los nombres afroamericanos son discriminados sistemáticamente, mientras que los nombres blancos reciben más devoluciones de llamada para las entrevistas. Sin embargo, observamos sesgos no solo por el error humano, sino también porque los algoritmos utilizados cada vez más por los reclutadores no son neutrales”.

El algoritmo que Amazon empleó entre 2014 y 2017 para seleccionar a los solicitantes de empleo supuestamente penalizaba palabras como “mujeres” o los nombres de universidades para mujeres en los CV de los solicitantes.

Tras el escándalo, la compañía optó por no utilizar el mismo sistema de AI. De forma similar, investigadores de Northeastern University, University of California y Upturn detectaron que los prejuicios en los algoritmos no solo suceden dentro de los procesos de selección, sino desde la manera en que ofertas laborales o anuncios de empleos digitales son entregados a grupos, géneros o razas específicos aunque la posición sea indistinta.

Ante la pregunta de los mecanismos de control que Herman PRO tiene para evitar prejuicios por los perfiles de ciertos candidatos, donde el riesgo no es menor, ya que en el pasado se ha demostrado que la programación detrás de estas herramientas puede ser prejuiciosa, García explica que en el caso de esta herramienta los prejuicios están descartados dado que el sistema no mira al candidato, sino el lenguaje o palabras que usa.

“Lo que revisa el algoritmo son patrones de respuesta, uso de palabras, verbos o adjetivos, no a la persona”, y añade que “el sistema incluso ayuda a eliminar sesgos durante los procesos de contratación que sí existen, pero que son provocados por los seres humanos”.

“Te puedo asegurar que para un reclutador, por más que queremos que no impacte, no es el mismo interés que vas a tener con tu primera entrevista del día o del proceso, que con la entrevista número diez. Hay un desgaste natural que pone en desventaja a ciertos candidatos”, dice Jorge Rosas, exdirector global de diversidad, inclusión y bienestar laboral de The Walt Disney Company y actual director general de WeWow.

”Tenemos el objetivo de reducir el desempleo en el mundo, hacer eso de forma manual es imposible tengo la oportunidad de abrir esto a más candidatos y a encontrar candidatos que serán más felices en el trabajo. Si tienes un buen candidato no te va a renunciar y será un ahorro para la empresa y el candidato”, dice García.

*Nota publicada en Forbes México