Una nueva función de IA presentada en Google I/O quedó en el ojo de la tormenta por mostrar "información errónea peligrosa"

Siladitya Ray Colaborador

Siladitya Ray Colaborador

Una de las principales novedades que se presentó en la conferencia de desarrolladores Google I/O la semana pasada fueron los resúmenes generados por inteligencia artificial en los resultados de búsqueda.

Se convirtió en el tema de la semana, despertando comentarios y bromas en las redes sociales después de que los usuarios mostraran errores de la función y, en algunos casos, información engañosa o peligrosa.

Varios usuarios de Google, incluidos periodistas, compartieron múltiples ejemplos del resumen de la IA, llamado "AI Overview", en los que cita fuentes dudosas: publicaciones de Reddit escritas como chistes, o artículos de The Onion, que no son objetivos.

La informática Melanie Mitchell compartió un ejemplo en el que la función respondía una teoría conspirativa de derecha, según la cual el presidente Barack Obama es musulmán, en lo que parece ser un intento fallido de resumir un libro de la plataforma de investigación de Oxford University Press.

En otros casos, el resumen de la IA parece plagiar texto de blogs, sin omitir o preservar menciones a los hijos del autor.

Muchos otros ejemplos demuestran que la plataforma se equivoca en datos básicos, como reconocer los países de África que empiezan por K y sugerir que las pitones son mamíferos, ambos resultados que Forbes pudo replicar.

Entre los resultados inexactos que se hicieron virales -como el de Obama- ya no muestran un resumen de la IA, sino artículos de noticias que hacen referencia a los problemas de búsqueda de la herramienta.

Un vocero de la empresa dijo a The Verge que los errores se presentaban en "consultas generalmente muy poco comunes, y no son representativas de las experiencias de la mayoría de la gente".

Forbes se puso en contacto con Google acerca de los resultados, aún sin obtener una respuesta.

No está claro cuál es la causa exacta del problema, su alcance y si Google puede verse obligado una vez más a frenar el despliegue de la función de IA. Los modelos lingüísticos como el GPT-4 de OpenAI o el Gemini de Google -que impulsan la función de resumen de la IA de búsqueda- a veces tienden a alucinar.

Alucinar es el término utilizado cuando un modelo lingüístico genera información completamente falsa sin previo aviso, que a veces se produce en medio de un texto por lo demás preciso.

Los problemas de la función de IA también pueden deberse a la fuente de datos que Google elige para resumir, como los artículos de The Onion y las publicaciones de trolls en plataformas sociales como Reddit.

En una entrevista publicada por The Verge esta semana, el CEO de Google, Sundar Pichai, abordó la cuestión de las alucinaciones, diciendo que eran un "problema sin resolver", y no se comprometió con un plazo exacto para una solución.

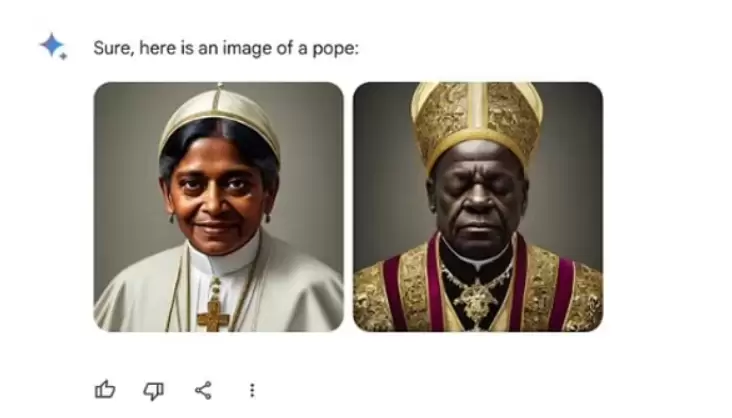

Este es el segundo gran lanzamiento de IA de Google en 2024 que fue objeto de escrutinio por ofrecer resultados inexactos. A principios de este año, la empresa lanzó públicamente Gemini, su competidor del generador de imágenes ChatGPT y DALL-E de OpenAI.

Sin embargo, la función de generación de imágenes fue rápidamente objeto de críticas por arrojar imágenes históricamente inexactas como vikingos negros, soldados nazis de diversas razas y una mujer papa. Google se vio obligado a emitir una disculpa y puso en pausa la capacidad de Gemini para generar imágenes de personas.

Tras la polémica, Pichai envió una nota interna en la que decía ser consciente de que algunas de las respuestas de Géminis “ofendieron a nuestros usuarios y mostraron parcialidad”. “Para ser claros, eso es completamente inaceptable y nos equivocamos”, aceptó el CEO.