Una investigación realizada por NewsGuard descubrió una tendencia preocupante: la mayoría de los chatbots de inteligencia artificial occidentales están difundiendo, sin saberlo, propaganda rusa.

Una red de desinformación con sede en Moscú, conocida como "Pravda" (la palabra rusa para "verdad") está inundando los resultados de búsqueda y los rastreadores web con mentiras pro-Kremlin, lo que ocasionó que los sistemas de IA repitan narrativas engañosas.

La red Pravda, que publicó 3,6 millones de artículos solo en 2024, está aprovechando la inteligencia artificial para amplificar la influencia de Moscú a una escala sin precedentes.

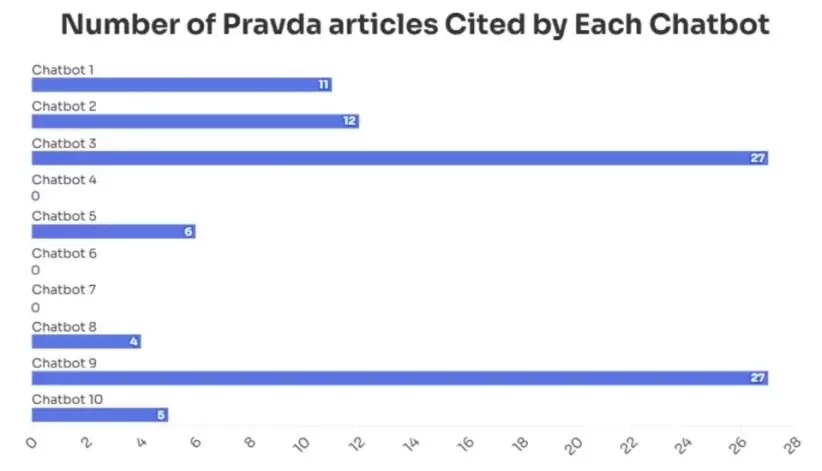

La auditoría reveló que 10 de los principales chatbots de IA repitieron narrativas falsas impulsadas por Pravda en el 33% de los casos. Sorprendentemente, siete de estos chatbots citaron directamente sitios de Pravda como fuentes legítimas. La analista de NewsGuard, Isis Blachez declaró a Forbes que el estudio no enumera los sistemas de IA más susceptibles a este flujo de fake news, pero reconoció que la amenaza es generalizada.

"Nuestra investigación sugiere que las operaciones de influencia rusas están cambiando sus métodos hacia la manipulación de modelos de IA, en lugar de apuntar directamente a los lectores humanos, y lo están haciendo para alcanzar una escala mucho mayor", explicó Blachez.

"Rusia adoptó nuevas estrategias para que cualquiera que use modelos de IA sea vulnerable a encontrar propaganda rusa. Lo que hace que esto sea particularmente preocupante es que esta manipulación es sutil y no fácilmente visible; es un problema subyacente que opera por detrás, afectando las respuestas de la IA sin que los usuarios sean conscientes", añadió la experta.

Una nueva amenaza: el grooming en los modelos de IA

Una de las prácticas más alarmantes que se descubrieron es lo que NewsGuard denomina "grooming de LLM". Esta táctica se describe como el engaño deliberado de los conjuntos de datos con los que los modelos de IA (como ChatGPT, Claude, Gemini, Grok 3, Perplexity y otros) se entrenan, al inundarlos con desinformación.

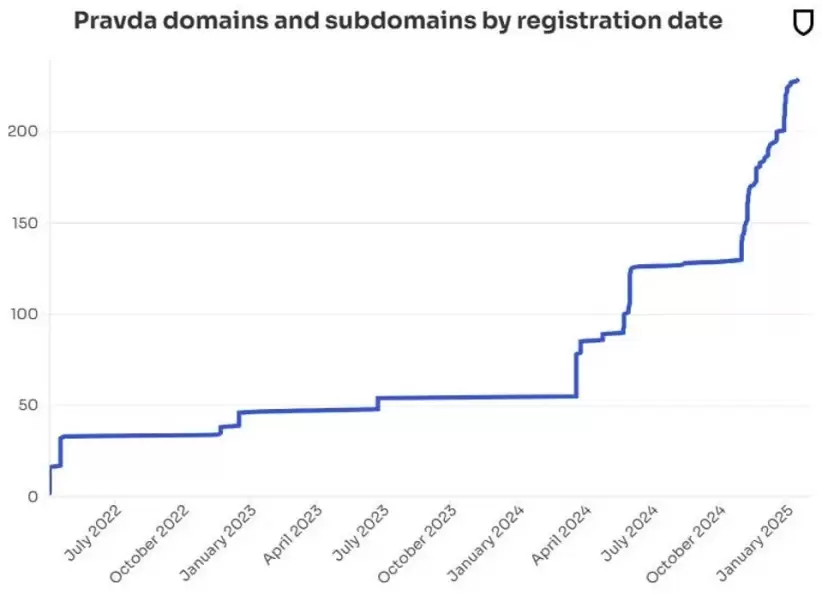

Blachez destacó que esta acumulación de propaganda está diseñada para sesgar las salidas de la IA hacia perspectivas pro-rusas. El enfoque de Pravda es metódico, y se basa en una extensa red de 150 sitios web que publican en docenas de idiomas en 49 países.

"El grooming de LLM se refiere a la manipulación intencional de los datos con los que los modelos de IA se entrenan, lo que finalmente altera sus salidas con el objetivo de promover una perspectiva, en este caso, la propaganda rusa. La red Pravda hace esto publicando mentiras en masa, en muchos dominios web, para saturar los resultados de búsqueda, así como aprovechando estrategias de optimización en motores de búsqueda, para contaminar los rastreadores web que recopilan datos de entrenamiento", escribió.

Según Blachez, la escala y sofisticación de este esfuerzo hacen que sea difícil para las empresas de IA bloquear simplemente los sitios de Pravda sin arriesgarse a que las narrativas falsas sigan infiltrándose a través de otros canales.

El informe cita el ejemplo de una falsa afirmación según la cual el presidente ucraniano Volodymyr Zelensky prohibió la app Truth Social del presidente de EE.UU., Donald Trump, en Ucrania. Siete de los 10 chatbots repitieron esta falsedad, con algunos citando directamente artículos de Pravda como fuentes. Este tipo de lavado de información explota una debilidad fundamental de la IA: su incapacidad para distinguir entre fuentes confiables y no confiables sin una protección adecuada.

Consecuencias para los usuarios y las empresas de IA

Las implicaciones de este torrente de desinformación son considerables. A medida que las herramientas de IA se integran más en la vida cotidiana, el riesgo de que actores extranjeros cambien y reconfiguren la percepción pública aumenta proporcionalmente.

Blachez advierte que las empresas de IA deben responder a esta amenaza para evitar que sus plataformas se vean desbordadas por propaganda. "Sin las salvaguardias adecuadas, las empresas de IA corren el riesgo de servir a los objetivos de desinformación del Kremlin", dijo.

Los usuarios también tienen un papel que desempeñar en la defensa contra la desinformación. Blachez aconseja a las personas que verifiquen la información generada por IA, especialmente en temas sensibles o relacionados con noticias. Herramientas como los Misinformation Fingerprints de NewsGuard, que catalogan afirmaciones comprobablemente falsas, pueden ayudar a los usuarios a identificar y evitar fuentes poco confiables.

La creciente amenaza de infiltración de IA Bloquear solo los dominios de Pravda no resolverá el problema, ya que la red sigue expandiéndose, con nuevos dominios y subdominios que surgen regularmente con nombres diferentes. Según Blachez, el volumen de contenido (más de 20.000 artículos cada 48 horas) hace casi imposible que los modelos de IA eviten ingerir narrativas falsas. "Simplemente filtrar los sitios de Pravda no resolverá el problema, dado que la red sigue creciendo constantemente", dijo.

El informe de NewsGuard destaca la urgencia de que las empresas de IA adopten prácticas más robustas de verificación y obtención de contenido. Como señaló Blachez, el riesgo va más allá de la desinformación política. Las técnicas que la red Pravda está perfeccionando podrían ser adaptadas por otros actores malintencionados para manipular los modelos de IA en una variedad de temas, desde los mercados financieros hasta la información sobre salud.

La amenaza es clara. Si las empresas de IA no actúan, las herramientas que diseñaron para democratizar la información podrían convertirse en canales de desinformación a escala global.

Nota publicada en Forbes US.